Конспект урока по Информатике «Количество информации в сообщении о неравновероятном событии. Формула Шеннона» 10 класс

Автор: Лузгина Наталия Геннадьевна, учитель информатики I кв.категории МБОУ «СОШ №11» г.Балахна Нижегородской обл.

Урок на тему «Количество информации в сообщении о неравновероятном событии.

Формула Шеннона».

(10 класс, профильный уровень, по учебнику Н.Д.Угриновича)

Цель урока:

Ввести формулу для определения количества информации для неравновероятных событий.

Задачи:

образовательная: познакомить учащихся с формулой для вычисления количества информации в сообщении о неравновероятном событии, формулой Шеннона; определить качественную связь между вероятностью события и количеством информации в сообщении об этом событии; научить решать задачи с использованием формулы Шеннона.

развивающая: способствовать развитию логического мышления (умения сравнивать, делать выводы), познавательной активности.

воспитывающая: прививать навыки самостоятельной работы, работы в парах; воспитывать умение высказывать личное мнение и прислушиваться к мнению других.

Используемые технологии: проблемного обучения.

Оборудование: интерактивная доска, проектор, презентация к уроку.

Ход урока

I. Постановка цели урока.

СЛАЙД 1. Учащимся предлагается устно решить задачу:

Задача: Какое сообщение содержит большее количество информации?

В библиотеке 8 шкафов. Книга нашлась в 3-м шкафу; (Отв.: 3 бит.)

Вася получил за экзамен оценку 4 (по 5-бальной системе единицы не ставят). (Отв.: 2 бит.)

Бабушка испекла 12 пирожков с капустой, 12 пирожков с повидлом. Маша съела один пирожок. (Отв.: 1 бит.)

Бабушка испекла 8 пирожков с капустой, 24 пирожка с повидлом. Маша съела один пирожок.

(В четвертом варианте учащиеся сталкиваются с ситуацией, когда события не равновероятны).

Действительно, далеко не все ситуации имеют одинаковые вероятности реализации. Существует много таких ситуаций, у которых вероятности реализации различаются. Например, если бросают несимметричную монету или «правило бутерброда».

СЛАЙД 2. Как вы думаете, какова же тема сегодняшнего урока? А цель?( исходя из выше обозначенной проблемы учащиеся сами формулируют тему и цель урока)

Ребята, вы абсолютно правы, сегодня на уроке мы должны ответить на вопрос: как вычислить количество информации в сообщении о неравновероятном событии.

II. Объяснение нового материала.

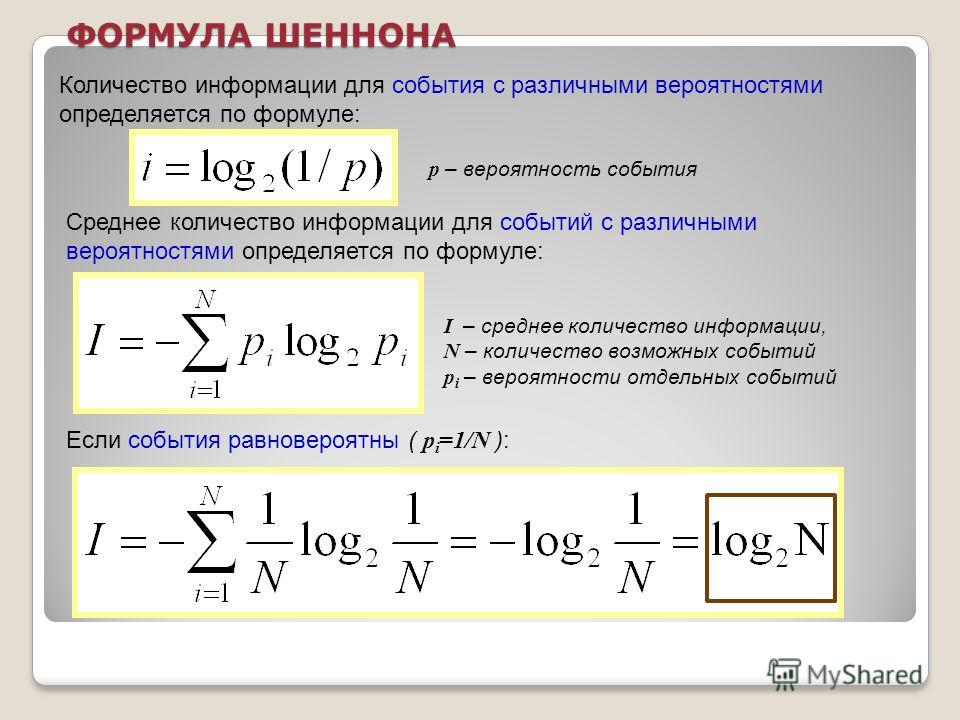

СЛАЙД 3. Для вычисления количества информации в сообщении о неравновероятном событии используют следующую формулу:

I=log2(1/p), где

I – это количество информации,

р – вероятность события.

Вероятность события выражается в долях единицы и вычисляется по формуле:

р=K/N, где

К – величина, показывающая сколько раз произошло интересующее нас событие,

N – общее число возможных исходов какого-то процесса.

СЛАЙД 4. Вернемся к нашей задаче.

Пусть:

К1 – это количество пирожков с повидлом, К1=24

К2 – количество пирожков с капустой, К2=8

N – общее количество пирожков, N = К1 +К2, N=24+8=32

Вычислим вероятность выбора пирожка с разной начинкой и количество информации, которое при этом было получено.

Вероятность выбора пирожка с повидлом: р1=24/32=3/4=0,75.

Вероятность выбора пирожка с капустой: р2=8/32=1/4=0,25.

Обращаем внимание учащихся на то, что в сумме все вероятности дают 1.

Вычислим количество информации, содержащееся в сообщении, что Маша выбрала пирожок с повидлом:

I1=log2(1/p1), I1= log2(1/0,75)= log21,3=1,15470 бит.

Вычислим количество информации, содержащееся в сообщении, если был выбран пирожок с капустой:

I2=log2(1/p2), I2= log2(1/0,25)= log24=2 бит.

При сравнении результатов вычислений получается следующая ситуация:

вероятность выбора пирожка с повидлом больше, чем с капустой, а информации при этом получилось меньше. Это не случайность, а закономерность.

Качественную связь между вероятностью события и количеством информации в сообщении об этом событии можно выразить так: чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

Вернемся к нашей задаче с пирожками. Мы еще не ответили на вопрос: сколько получим информации при выборе пирожка любого вида?

СЛАЙД 5. Ответить на этот вопрос нам поможет формула вычисления количества информации для событий с различными вероятностями, которую предложил в 1948 г. американский инженер и математик Клод Элвуд Шеннон.

американский инженер и математик Клод Элвуд Шеннон.

Если I-количество информации,

N-количество возможных событий,

рi — вероятности отдельных событий, где i принимает значения от 1 до N, то количество информации для событий с различными вероятностями можно определить по формуле:

СЛАЙД 6. можно расписать формулу в таком виде:

Знак минус в формуле не означает, что количество информации в сообщении – отрицательная величина. Объясняется это тем, что вероятность (р), согласно определению, 0. Т.к. Log числа, меньшего 1 (т.е. log pi) – величина отрицательная, то произведение вероятности на логарифм числа будет положительным.

Рассмотрим формулу на нашем примере:

I = — (р1∙log2p1 + р2∙log2p2),

I= — (0,25∙ log20,25+0,75∙ log20,75)≈-(0,25∙(-2)+0,75∙(-0,42))=0,815 бит

СЛАЙД 7. Теперь ответьте на вопрос задачи, которая была поставлена в начале урока: Какое сообщение содержит большее количество информации?

Теперь ответьте на вопрос задачи, которая была поставлена в начале урока: Какое сообщение содержит большее количество информации?

В библиотеке 8 шкафов. Книга нашлась в 3-м шкафу; (Отв.: 3 бит.)

Вася получил за экзамен 3 балла (по 5-бальной системе единицы не ставят). (Отв.: 2 бит.)

Бабушка испекла 12 пирожков с капустой, 12 пирожков с повидлом. Маша съела один пирожок. (Отв.: 1 бит.)

Бабушка испекла 8 пирожков с капустой, 24 пирожка с повидлом. Маша съела один пирожок. (Отв.: 0,815 бит.)

Ответ: в 1 сообщении.

Обратите внимание на 3 и 4 задачу. Сравните количество информации.

Мы видим, что количество информации достигает максимального значения, если события равновероятны.

Можно ли применить формулу К. Шеннона для равновероятных событий?

Если p1=p2=..=pn=1/N, тогда формула принимает вид:

Мы видим, что формула Хартли является частным случаем формулы Шеннона.

III. Закрепление изучаемого материала.

СЛАЙД 8.

Задача №1: (объясняет учитель)

В корзине лежат 32 клубка красной и черной шерсти. Среди них 4 клубка красной шерсти.

Сколько информации несет сообщение, что достали клубок красной шерсти? Сколько информации несет сообщение, что достали клубок шерсти любой окраски?

Дано: Кк=4;N=32

Найти: Iк, I

Решение:

Найдем количество клубков черной шерсти:

Кч=N- Кк; Кч=32-4=28

Найдем вероятность доставания клубка каждого вида:

pк= Кк/N, pк =4/32=1/8;

pч= Кч/N, pч =28/32=7/8;

Найдем количество информации, которое несет сообщение, что достали клубок красной шерсти:

Iк= log2(1/(1/ pк)), Iк = log2(1/1/8)= log28=3 бита

Найдем количество информации, которое несет сообщение, что достали клубок шерсти любой окраски:

Ответ: Iк=3 бит; I=0,547 бит

(Задачи 2-4 учащиеся решают в парах с дальнейшей защитой решения у доски).

Задача №2: В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика?

Задача №3: В озере обитает 12500 окуней, 25000 пескарей, а карасей и щук по 6250. Какое количество информации несет сообщение о ловле рыбы каждого вида. Сколько информации мы получим, когда поймаем какую-нибудь рыбу?

Задача №4: В коробке лежат кубики: 10 красных, 8 зеленых, 5 желтых, 12 синих. Вычислите вероятность доставания кубика каждого цвета и количество информации, которое при этом будет получено.

VI. Подведение итогов урока.

СЛАЙД 9. Ответьте на вопросы:

Объясните на конкретных примерах отличие равновероятного события от неравновероятного?

С помощью какой формулы вычисляется вероятность события?

Объясните качественную связь между вероятностью события и количеством информации в сообщении об этом событии?

В каких случаях применяется формула Шеннона для измерения количества информации?

В каком случае количество информации о событии достигает максимального значения?

V. Домашнее задание.

Домашнее задание.

СЛАЙД 10. §2.4 стр.111-113. Устно №2.3 стр.114-115. Письменно №2.3 стр.115

ИСТОЧНИКИ:

Н.Д.Угринович «Информатика и ИКТ». Учебник для10 класса, профильный уровень.

- http://marknet.narod.ru/spr/list5.htm Информатика. Справочный материал. Количество информации. Формулы Хартли и Шеннона

Н.Д.Угринович, методическое пособие «Информатика и ИКТ 8 -11 класс»

1.2. Формула Хартли измерения количества информации. Закон аддитивности информации — ЗФТШ, МФТИ

Как уже упоминалось выше, в качестве основной единицы измерения информации мы будем использовать бит. Соответственно, с точки зрения алфавитного подхода мы будем кодировать информацию при помощи нулей и единиц (двоичных знаков).

Поставим себе одну из наиболее часто встречающихся задач в теории информации. Пусть у нас есть `N` возможных равновероятных вариантов исходов некоторого события. Какое количество информации нам нужно получить, чтобы оставить только один вариант?

Например, пусть мы знаем, что некоторая интересная для нас книга находится на одной из полок нашего книжного шкафа, в котором `8` полок. Какое количество информации нам нужно получить, чтобы однозначно узнать полку, на которой находится книга?

Какое количество информации нам нужно получить, чтобы однозначно узнать полку, на которой находится книга?

Решим эту задачу с точки зрения содержательного и алфавитного подходов. Поскольку изначально в шкафу было `8` полок, а в итоге мы выберем одну, следовательно, неопределённость знания о местоположении книги уменьшится в `8` раз. Мы говорили, что один бит – это количество информации, уменьшающее неопределённость знания в `2` раза. Следовательно, мы должны получить `3` бита информации.

Теперь попробуем использовать алфавитный подход. Закодируем номера всех полок при помощи `0` и `1`. Получим следующие номера: `000, 001, 010, 011, 100, 101, 110, 111`. Для того чтобы узнать, на какой полке находится книга, мы должны узнать номер этой полки. Каждый номер состоит из `3` двоичных знаков. А по определению, `1` бит (в алфавитном подходе) – это количество информации в сообщении, состоящем из `1` двоичного знака. То есть мы тоже получим `3` бита информации.

Прежде чем продолжить рассмотрение поставленной общей задачи введём важное математическое определение.

Теперь вернёмся к нашей задаче. Итак, какое же количество информации нам нужно получить, чтобы выбрать один исход из `N` равновероятных? Ответ на этот вопрос даёт формула Хартли: `H=log_aN`, где `N` – это количество исходов, а `H` – количество информации, которое нужно получить для однозначного выбора `1` исхода. Основание логарифма обозначает единицу измерения количества информации. То есть если мы будем измерять количество информации в битах, то логарифм нужно брать по основанию `2`, а если основной единицей измерения станет трит, то, соответственно, логарифм берётся по основанию `3`.

Рассмотрим несколько примеров применения формулы Хартли.

Имеется `27` монет, одна из которых фальшивая и легче всех остальных. Сколько потребуется взвешиваний на двухчашечных весах, чтобы однозначно найти фальшивую монету?

В этой задаче неудобно использовать бит в качестве основной единицы измерения информации. Двухчашечные весы могут принимать три положения: левая чаша перевесила, значит, фальшивая монета находится в правой; правая чаша перевесила, значит, монета находится в левой; или же весы оказались в равновесии, что означает отсутствие фальшивой монеты на весах. Таким образом, одно взвешивание может уменьшить неопределённость в три раза, следовательно, будем использовать в качестве основной единицы измерения количес-тва информации трит.

Таким образом, одно взвешивание может уменьшить неопределённость в три раза, следовательно, будем использовать в качестве основной единицы измерения количес-тва информации трит.

По формуле Хартли `H = log _3 27 = 3` трита. Таким образом, мы видим, что для того чтобы найти фальшивую монету среди остальных, нам потребуется три взвешивания.

Логарифмы обладают очень важным свойством: `log_a(X*Y)=log_aX+log_aY`.

Если переформулировать это свойство в терминах количества информации, то мы получим закон аддитивности информации: Коли-чество информации`H(x_1, x_2)`, необходимое для установления пары `(x_1, x_2)`, равно сумме количеств информации `H(x_1)` и `H(x_2)`, необходимых для независимого установления элементов `x_1` и `x_2`:

`H(x_1,x_2)=H(x_1)+H(x_2)`.

Проиллюстрируем этот закон на примере. Пусть у нас есть игральная кость в форме октаэдра (с `8` гранями) и монета. И мы одновременно подбрасываем их вверх. Нужно узнать, какое количество информации несёт сообщение о верхней стороне монеты после падения (орёл или решка) и числе, выпавшему на игральной кости.

Игральная кость может упасть `8` различными способами, следовательно, по формуле Хартли можно вычислить, что, определив число, выпавшее на игральной кости, мы получаем `3` бита информации. Соответственно, монета может упасть только `2` способами и несёт в себе `1` бит информации. По закону аддитивности информации мы можем сложить полученные результаты и узнать, что интересующее нас сообщение несёт `4` бита информации.

Рассмотрим другой способ решения этой задачи. Если мы сразу рассмотрим все возможные исходы падения `2` предметов, то их будет `16` (кость выпадает `8` способами, а монета — орлом вверх, и кость выпадает `8` способами, а монета — решкой вверх). По формуле Хартли находим, что интересующее нас сообщение несёт `4` бита информации.

Калькулятор энтропии Шеннона| Теория информации

Создано Юлией Жулавинской

Отредактировано Bogna Szyk и Jack Bowater

Последнее обновление: 02 февраля 2023 г.

Содержание:- Как энтропия Шеннона используется в теории информации?

- Как рассчитать энтропию? — формула энтропии

- Интересные факты об энтропии — символ энтропии, пароль энтропия

Добро пожаловать в калькулятор энтропии Шеннона! Энтропия объекта или системы является мерой случайности внутри системы. В физике это определяется энергией, недоступной для выполнения работы. В этой статье мы объясним используемую в статистике форму энтропии — информационную энтропию. Продолжайте читать, чтобы узнать, как рассчитать энтропию, используя формулу энтропии Шеннона.

В физике это определяется энергией, недоступной для выполнения работы. В этой статье мы объясним используемую в статистике форму энтропии — информационную энтропию. Продолжайте читать, чтобы узнать, как рассчитать энтропию, используя формулу энтропии Шеннона.

У вас есть другие проблемы со статистикой или вы просто интересуетесь этой темой? Проверьте наш калькулятор нормального распределения!

Энтропия Шеннона, также известная как информационная энтропия или индекс энтропии Шеннона, является мерой степени случайности в наборе данных .

Используется для расчета неопределенности, связанной с появлением определенного символа в строке текста. Чем больше символов или чем более пропорциональна частота появления, тем сложнее будет предсказать, что будет дальше, что приведет к увеличению энтропии. Когда результат определен, энтропия равна нулю. 9n∑i=1n — оператор суммирования вероятностей от i до n .

В теории информации энтропия имеет несколько единиц. Это зависит от основания логарифма — b\размер сноски bb. Обычно, когда мы имеем дело с компьютерами, он равен 2 , а единица известна как бит (также называемая shannon ). Наш калькулятор энтропии Шеннона использует эту базу. Когда основание равно Число Эйлера , e , энтропия измеряется в нац . Если это 10 , единицей измерения является dit , ban или hartley .

Используем для примера формулу энтропии Шеннона:

- У вас есть последовательность чисел: 1 0 3 5 8 3 0 7 0 1\footnotesize 1\space0\space3\space5\space8\space3\space0\space7\space0 \space11 0 3 5 8 3 0 7 0 1.

- Каждый отдельный символ имеет разную вероятность появления:

- p(1)=2/10\размер сноски p(1) = 2 / 10p(1)=2/10.

- p(0)=3/10\размер сноски p(0) = 3/10p(0)=3/10.

- p(3)=2/10\размер сноски p(3) = 2 / 10p(3)=2/10.

- p(5)=1/10\размер сноски p(5) = 1/10p(5)=1/10.

- p(8)=1/10\размер сноски p(8) = 1/10p(8)=1/10.

- p(7)=1/10\размер сноски p(7) = 1/10p(7)=1/10.

- Энтропия Шеннона равна:

- После ввода значений:

H=0,2∗log2(10,2)+0,3∗log2(10,3)+0,2∗log2(10,2)+0,1∗log2(10,1)+0,1∗log2(10,1)+0,1∗log2( 10.1)\размер сноски H = 0,2 * log_2(\frac{1}{0,2}) + 0,3 * log_2(\frac{1}{0,3}) + 0,2 * log_2(\frac{1}{0,2}) + 0,1 * log_2(\frac{1}{0,1}) + 0,1 * log_2(\frac{1}{0,1}) + 0,1 * log_2(\frac{1}{0,1})H=0,2*log2(0,21)+ 0,3∗log2(0,31)+0,2∗log2(0,21)+0,1∗log2(0,11)+0,1∗log2(0,11)+0,1∗log2(0,11) - H=2,44644\размер сноски H = 2,44644H=2,44644.

Знайте, что вы знаете, как вычислить энтропию Шеннона самостоятельно! Продолжайте читать, чтобы узнать некоторые факты об энтропии!

Интересные факты об энтропии — символ энтропии, пароль энтропии

Термин «энтропия» был впервые введен Рудольфом Клаузиусом в 1865 году. Он происходит от греческих слов «эн-» (внутри) и «троп» (преобразование). Раньше это было известно как «значение эквивалентности». В физике и химии символом энтропии является заглавная

Вы также можете встретить фразу « энтропия пароля «. Это измерение того, насколько случайным является пароль. Он учитывает количество символов в вашем пароле и пул уникальных символов, которые вы можете выбрать (например, 26 символов нижнего регистра, 36 буквенно-цифровых символов).

Чем выше энтропия вашего пароля, тем сложнее его взломать.

Чем выше энтропия вашего пароля, тем сложнее его взломать.Экологи используют энтропию как меру разнообразия. С экологической точки зрения лучше всего, если рельеф будет видово-дифференцированным. Более высокая энтропия означает большее разнообразие.

Программисты имеют дело с особой интерпретацией энтропии, называемой сложностью программирования : узнайте больше на нашем калькуляторе цикломатической сложности.

Понравился наш калькулятор энтропии Шеннона? Проверьте калькулятор парадокса дня рождения дальше!

Julia Żuławińska

Вероятности (вы можете ввести до 10 значений)

Событие 1

Событие 2

Событие 3

Энтропия Шеннона равна 0

Ознакомьтесь с 161 похожим калькулятором статистики

10-гранный кубик22 кубик4-гранный кубик… Еще 158

Значение теории информации в машинном обучении

Взгляд на то, что такое теория информации и как на нее опирается машинное обучение.

Фото Янко Ферлича с сайта Pexels

Фото Янко Ферлича с сайта PexelsИнформация . Этот термин использовался во всех возможных сценариях. Но это правильно, мир держится на Информации. Итак, что это? Самый простой способ объяснить это на примере. Представьте, что вы ходите по магазинам и купили несколько товаров. Вы знаете цены на эти предметы; следовательно, это необработанные данные для вас. Позже, когда вы будете расплачиваться у прилавка, кассир просканирует эти предметы и сообщит вам их суммарную стоимость. Чтобы уточнить, кассир обработает количество предметов со стоимостью каждого предмета и даст вам фиксированное число, которое вы можете оплатить. В каком-то смысле кассир обработал необработанные данные (цены отдельных товаров) и предоставил вам информацию (окончательную сумму счета). Таким образом, я могу описать информацию как обработанные данные, имеющие контекстное значение.

Чтобы продолжить, вот два сообщения:

а) Я не пошел на работу.

б) Я не пошел на работу, потому что был на приеме у врача.

Очевидно, что второе сообщение содержит больше информации, чем первое. Но как мне определить, что такое «больше»? Как мне это количественно оценить? Вот где на помощь приходит теория информации! В следующем разделе будет рассмотрена область теории информации и важные концепции в ней.

Исследователи размышляли над количественной оценкой информации с начала 19 века.00-х, а в 1948 году Клод Шеннон опубликовал феноменальную статью под названием «Математическая теория коммуникации». Эта статья положила начало области теории информации. Теория информации, по определению, является изучением количественного определения, хранения и передачи информации. Но это гораздо больше. Он внес существенный вклад в область статистической физики, компьютерных наук, экономики и т. д.

Основное внимание в статье Шеннона было уделено общей системе связи, поскольку он работал в Bell Labs, когда опубликовал статью. Он установил довольно много важных понятий, таких как информационная энтропия и избыточность. В настоящее время его основные принципы применяются в области сжатия данных без потерь, сжатия данных с потерями и кодирования каналов.

В настоящее время его основные принципы применяются в области сжатия данных без потерь, сжатия данных с потерями и кодирования каналов.

Методы, используемые в теории информации, носят вероятностный характер и обычно имеют дело с двумя конкретными величинами, а именно. Энтропия и взаимная информация. Давайте углубимся в эти два термина.

Энтропия Шеннона (или просто энтропия)

Энтропия — это мера неопределенности случайной величины или количества информации, необходимой для описания переменной. Предположим, что х — дискретная случайная величина, и она может принимать любое значение, определенное в наборе, х. Предположим, что в этом сценарии множество конечно. Распределение вероятностей для x будет p(x) = Pr{ χ = x }, x ∈ χ . Имея это в виду, энтропия может быть определена как

Энтропия Единицей энтропии является бит. Если вы обратите внимание на формулу, энтропия полностью зависит от вероятности случайной величины , а не от самого значения x . Перед формулой стоит знак минус, что делает ее всегда положительной или равной 0. Если энтропия равна 0, новой информации не требуется. Я продемонстрирую реализацию этой формулы на примере.

Перед формулой стоит знак минус, что делает ее всегда положительной или равной 0. Если энтропия равна 0, новой информации не требуется. Я продемонстрирую реализацию этой формулы на примере.

Рассмотрим сценарий подбрасывания монеты. Есть два возможных исхода, орел или решка, с равными вероятностями. Если мы оценим это количественно, x ∈ {орел, решка}, и p (орел) = 0,5 и p (решка) = 0,5. Если мы подставим эти значения в формулу:

Расчет энтропии в событии подбрасывания монетыСледовательно, энтропия равна 1 биту, т. е. результат подбрасывания монеты может быть полностью выражен в 1 бите. Итак, чтобы интуитивно выразить концепцию энтропии Шеннона, она понимается как «какой длины должно быть сообщение, чтобы полностью передать свою ценность». Я хочу погрузиться немного глубже и обсудить концепции совместной энтропии, условной энтропии и относительной энтропии.

Совместная и условная энтропия

Раньше я определял энтропию для одной случайной величины, но теперь я расширю ее для пары случайных величин. Это простая агрегация, поскольку мы можем определить пару переменных ( X , Y ) как одну случайную переменную с векторным значением.

Это простая агрегация, поскольку мы можем определить пару переменных ( X , Y ) как одну случайную переменную с векторным значением.

Совместная энтропия H ( X , Y ) пары дискретных случайных величин ( X , Y ) с совместным распределением p ( x , y ) определяется как

Совместная энтропияЭто также может быть представлено в терминах ожидаемого значения.

Совместная энтропия (Форма ожидаемого значения)Аналогично, для условной энтропии H ( Y |X) определяется как:

Условная энтропияИнтуитивно это среднее значение энтропии Y при заданном X по всем возможным значениям X . Учитывая тот факт, что ( X , Y ) ~ p ( x , y ), условная энтропия также может быть выражена через математическое ожидание.

Условная энтропия (форма ожидаемого значения) Давайте попробуем пример, чтобы лучше понять условную энтропию. Рассмотрим исследование, в котором испытуемых спрашивали:

Рассмотрим исследование, в котором испытуемых спрашивали:

I) курили ли они, пили или не делали ни того, ни другого.

II) если у них была какая-либо форма рака

Теперь я представлю ответы на эти вопросы как две разные дискретные переменные, принадлежащие к совместному распределению.

Слева вы видите таблицу данных, в которой 10 испытуемых ответили на вопросы. У нас есть три разных варианта для переменной Activity (я назову ее X). Второй столбец показывает, есть ли у субъекта рак (переменная Y). Здесь есть две возможности, то есть «Да» или «Нет». Поскольку мы еще не имеем дело с непрерывными переменными, я оставил эти переменные дискретными. Давайте создадим таблицу вероятностей, которая сделает сценарий более понятным.

Таблица вероятностей для приведенного выше примераДалее я вычислю значение предельной вероятности p ( x ) для всех возможных значений X.

Предельная вероятность X На основании таблицы вероятностей мы можем подставить значение в условную энтропию формула.

Относительная энтропия

Относительная энтропия несколько отличается, поскольку она переходит от случайных величин к распределениям. Это мера расстояния между двумя распределениями. Более инстинктивно можно выразить это так: относительная энтропия или KL-дивергенция, обозначаемая как D ( p || q ), является мерой неэффективности предположения, что распределение равно q , когда истинное распределение p . Его можно определить как:

Относительная энтропияОтносительная энтропия всегда неотрицательна и может быть равна 0, только если p = q . Хотя здесь следует отметить, что это не истинное расстояние, поскольку оно не симметрично по своей природе. Но его часто рассматривают как «расстояние» между распределениями.

Давайте рассмотрим пример, чтобы укрепить эту концепцию! Пусть X = {0,1} и рассмотрим два распределения p и q на X. Пусть p (0) = 1 — r , p (1) = 909r 38 и пусть q (0) = 1 — с , q (1) = с. Тогда

Пусть p (0) = 1 — r , p (1) = 909r 38 и пусть q (0) = 1 — с , q (1) = с. Тогда

Я также хотел бы продемонстрировать свойство несимметричности, поэтому я также вычислю D ( q || стр. ).

Относительная энтропия для q||pЕсли r = s, D ( p || q ) = D ( q || p ) = 0. значения, например, r = 1/2 и s = 1/4.

Как видите, D ( p || q ) ≠ D ( q || p ).

Теперь, когда мы обсудили различные типы энтропий, мы можем перейти к взаимной информации.

Взаимная информация

Взаимная информация — это мера количества информации, которую одна случайная величина содержит о другой случайной величине. В качестве альтернативы его можно определить как уменьшение неопределенности одной переменной благодаря знанию другой. Техническое определение для него будет следующим:

Техническое определение для него будет следующим:

Рассмотрим две случайные величины X и Y с общей функцией массы вероятности p ( x , y ) и массовые функции предельной вероятности p ( x ) и p ( y ). Взаимная информация I ( X ; Y ) представляет собой относительную энтропию между совместным распределением и распределением продукта p ( x ) p ( y ).

Взаимная информация также может быть выражена в терминах энтропии. Вывод довольно забавный, но я воздержусь, так как это может загромождать статью.

Взаимная информация w.r.t. ЭнтропияИз приведенного выше уравнения мы видим, что взаимная информация представляет собой уменьшение неопределенности X благодаря знанию Y . Существует диаграмма Венна, прекрасно описывающая взаимосвязь.

Связь между взаимной информацией и энтропией Давайте рассмотрим пример, чтобы лучше понять это. Я могу использовать пример связи между курением, употреблением алкоголя и раком, который я использовал при объяснении энтропии. Мы видели, что H ( Y | X) = 0,8184 бит. Для расчета Взаимной Информации мне нужен еще один терм H ( Y ). H ( Y ), в этом случае будет:

Я могу использовать пример связи между курением, употреблением алкоголя и раком, который я использовал при объяснении энтропии. Мы видели, что H ( Y | X) = 0,8184 бит. Для расчета Взаимной Информации мне нужен еще один терм H ( Y ). H ( Y ), в этом случае будет:

Следовательно, взаимная информация определяется:

Расчет взаимной информации В качестве альтернативы я также могу использовать H ( X ) и H ( X | Y ) для вычисления взаимной информации, и это даст тот же результат. Мы видим, что знание X так мало значит для неопределенности переменной Y. Позвольте мне изменить отрывок из этого примера и привести вас к тому, как все это имеет смысл в машинном обучении. Предположим, что X — переменная-предиктор, а Y — предсказываемая переменная. Взаимная информация между ними может быть отличным предшественником, чтобы проверить, насколько полезной будет эта функция для прогнозов. Давайте обсудим значение теории информации в машинном обучении.

Давайте обсудим значение теории информации в машинном обучении.

Существует довольно много приложений, но я остановлюсь на нескольких популярных.

Деревья решений

Фото Min An из Pexels Деревья решений (DT) — это непараметрический контролируемый метод обучения, используемый для классификации и регрессии. Цель состоит в том, чтобы создать модель, которая предсказывает значение целевой переменной, изучая простые правила принятия решений, выведенные из характеристик данных. Используемый здесь базовый алгоритм называется ID3 и был разработан Россом Куинланом. Он использует подход жадного поиска сверху вниз и включает в себя разделение данных на подмножества с однородными данными. Алгоритмы ID3 определяют разделение, вычисляя однородность выборки с использованием энтропии. Если выборка однородна, энтропия равна 0, а если выборка равномерно разделена, она имеет максимальную энтропию. Но энтропия не имеет прямого отношения к построению деревьев. Алгоритм основан на получении информации, основанном на снижении энтропии после разделения набора данных на атрибут. Если вы подумаете интуитивно, то увидите, что на самом деле это Взаимная Информация, о которой я упоминал выше. Взаимная информация уменьшает неопределенность одной переменной при заданном значении другой. В DT мы вычисляем энтропию прогнозируемой переменной. Затем набор данных разделяется на основе энтропии, и энтропия результирующей переменной вычитается из предыдущего значения энтропии. Это получение информации и, очевидно, взаимная информация в игре.

Если вы подумаете интуитивно, то увидите, что на самом деле это Взаимная Информация, о которой я упоминал выше. Взаимная информация уменьшает неопределенность одной переменной при заданном значении другой. В DT мы вычисляем энтропию прогнозируемой переменной. Затем набор данных разделяется на основе энтропии, и энтропия результирующей переменной вычитается из предыдущего значения энтропии. Это получение информации и, очевидно, взаимная информация в игре.

Перекрестная энтропия

Перекрестная энтропия — это концепция, очень похожая на относительную энтропию. Относительная энтропия — это когда случайная величина сравнивает истинное распределение p с тем, как аппроксимированное распределение q отличается от p в каждой точке выборки (расхождение или разница). Тогда как кросс-энтропия напрямую сравнивает истинное распределение p с приблизительным распределением q . Кросс-энтропия — это термин, широко используемый в области глубокого обучения. Используется как функция потерь, которая измеряет производительность модели классификации, выходной сигнал которой представляет собой значение вероятности от 0 до 1. Потери кросс-энтропии увеличиваются по мере того, как прогнозируемая вероятность отличается от фактической метки.

Используется как функция потерь, которая измеряет производительность модели классификации, выходной сигнал которой представляет собой значение вероятности от 0 до 1. Потери кросс-энтропии увеличиваются по мере того, как прогнозируемая вероятность отличается от фактической метки.

KL-Divergence

K-L Divergence или относительная энтропия также является темой, включенной в литературу по глубокому обучению, особенно в VAE. Вариационные автоэнкодеры принимают входные данные в виде распределений Гаусса, а не дискретных точек данных. Оптимально, чтобы распределения VAE были регуляризованы, чтобы увеличить количество перекрытий в скрытом пространстве. Дивергенция K-L измеряет это и добавляется к функции потерь.

K-L Divergence также используется в t-SNE. tSNE — это метод уменьшения размерности, который в основном используется для визуализации данных в больших размерностях. Он преобразует сходство между точками данных в совместные вероятности, а пытается минимизировать расхождение Кульбака-Лейблера между совместными вероятностями низкоразмерного вложения и многомерными данными.

Расчет дисбаланса в распределении целевых классов

Энтропия может использоваться для расчета дисбаланса целевых классов. Если мы рассматриваем прогнозируемую функцию как случайную величину с двумя классами, сбалансированный набор (разделение 50/50) должен иметь максимальную энтропию, как мы видели в случае подбрасывания монеты. Но если разделение искажено и один класс имеет распространенность 90%, то можно получить меньше знаний, а значит, и меньшую энтропию. Реализуя цепное правило для вычисления энтропии, мы можем проверить, сбалансирована ли целевая переменная мультикласса в одном количественном значении, хотя и в среднем, которое маскирует отдельные вероятности.

Теория информации — захватывающая область, которая внесла большой вклад во многие области. Машинное обучение, будучи одним из них, не полностью использовало все, что может предложить теория информации. Я чувствую, что в контексте машинного обучения можно открыть множество концепций теории информации, и меня, как специалиста по данным, это очень воодушевляет.

Чем выше энтропия вашего пароля, тем сложнее его взломать.

Чем выше энтропия вашего пароля, тем сложнее его взломать.

Leave A Comment