Алгоритм, записанный на естественном языке, обрабатывающий цепочки символов или списки

Скачать .pdf

Незнайка → ОГЭ → Информатика

Ответами к заданиям являются слово, словосочетание, число или последовательность слов, чисел.

1

1

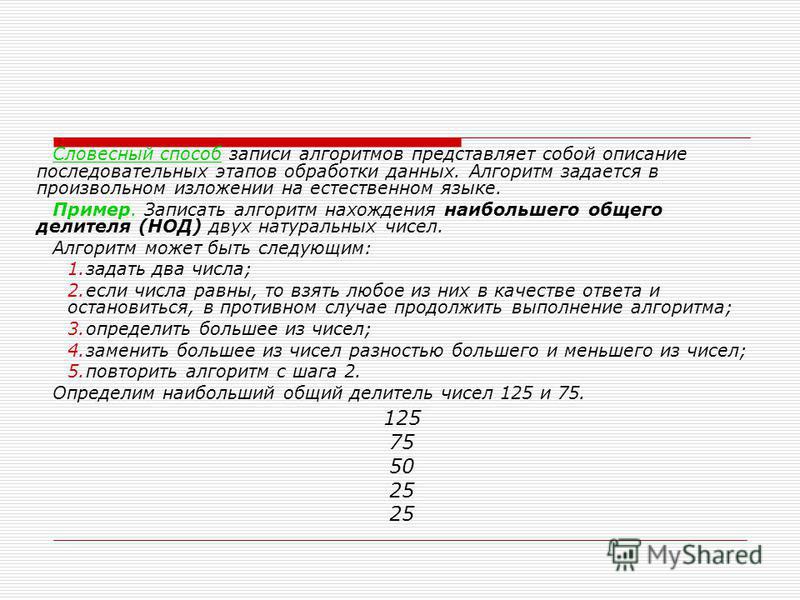

Некоторый алгоритм из одной цепочки символов получает новую цепочку следующим образом. Сначала вычисляется длина исходной цепочки символов; если она четна, то в середину цепочки символов добавляется символ X, а если нечетна, то в конец цепочки добавляется символ Z. В полученной цепочке символов каждая буква заменяется буквой, следующей за ней в латинском алфавите (А — на В, В — на С и т. д., a Z — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.

Например, если исходной была цепочка CAT, то результатом работы алгоритма будет цепочка DBUA, а если исходной была цепочка POLE, то результатом работы алгоритма будет цепочка

Дана цепочка символов START. Какая цепочка символов получится, если к данной цепочке применить описанный алгоритм дважды (т.е. применить алгоритм к данной цепочке, а затем к результату вновь применить алгоритм)?

Латинский алфавит: ABCDEFGHIJKLMNOPQRSTUVWXYZ

2

2

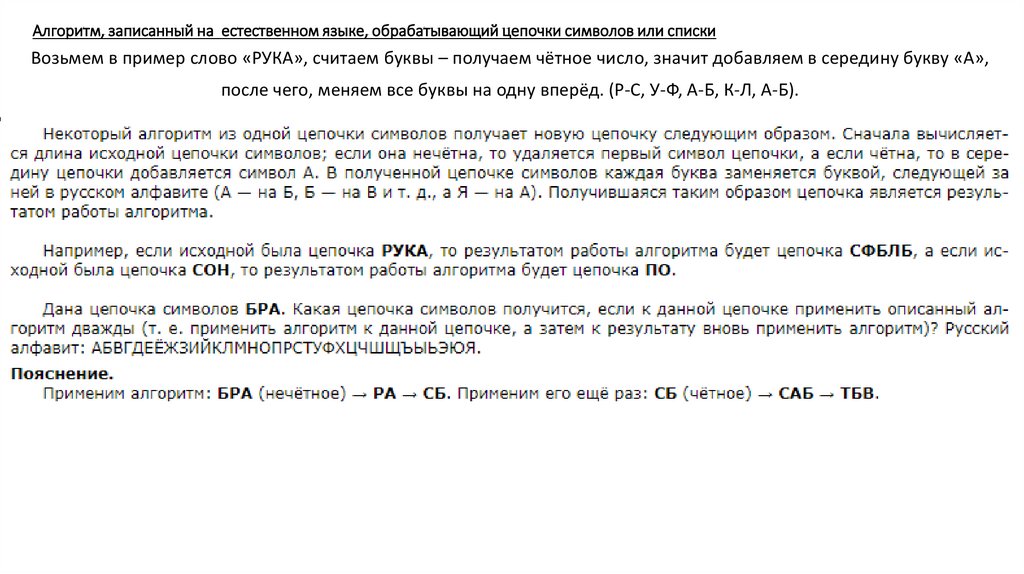

Некоторый алгоритм из одной цепочки символов получает новую цепочку следующим образом. Сначала вычисляется длина исходной цепочки символов; если она чётна, то в середину цепочки символов добавляется символ А, а если нечётна, то из цепочки удаляется символ, стоящий в её середине. В полученной цепочке символов каждая буква заменяется буквой, следующей за ней в русском алфавите (

Например, если исходной была цепочка МАК, то результатом работы алгоритма будет цепочка НЛ, а если исходной была цепочка ЗОЛА, то результатом работы алгоритма будет цепочка ИПБМБ.

Дана цепочка символов ТОРТ. Какая цепочка символов получится, если к данной цепочке применить описанный алгоритм дважды (т. е. применить алгоритм к данной цепочке, а затем к результату вновь применить алгоритм)?

Русский алфавит: АБВГДЕЁЖЗИЙКЛМНОПРСТУФХЦЧШЩЪЫЬЭЮЯ

3

3

Автомат получает на вход четырёхзначное десятичное число. По полученному числу строится новое десятичное число по следующим правилам.

1. Вычисляются два числа — сумма двух старших и сумма двух младших разрядов.

2. Полученные два числа записываются друг за другом в порядке невозрастания (без разделителей).

Например, исходное число: 1277. Поразрядные суммы: 3, 14. Результат: 143. Определите, сколько из приведённых ниже чисел могут получиться в результате работы автомата.

1818 189 183 1918 1819 318 918 118

В ответе запишите только количество чисел.

4

4

Автомат получает на вход четырёхзначное десятичное число. По полученному числу строится новое десятичное число по следующим правилам.

По полученному числу строится новое десятичное число по следующим правилам.

1. Вычисляются два числа — сумма всех цифр и произведение всех цифр исходного числа.

2. Полученные два числа записываются друг за другом в порядке невозрастания (без разделителей).

Пример. Исходное число: 7712. Поразрядные суммы: 17, 98. Результат: 9817. Определите, сколько из приведённых ниже чисел могут получиться в результате работы автомата.

63 89 98 200 291 1311 656136 756423

В ответе запишите только количество чисел.

5

5

Некоторый алгоритм из одной цепочки символов получает новую цепочку следующим образом. Сначала вычисляется длина исходной цепочки символов; если она чётна, то в середину цепочки символов добавляется символ Ч, а если нечётна, то в конец цепочки добавляется символ Н. В полученной цепочке символов каждая буква заменяется буквой, следующей за ней в русском алфавите (А — на Б, Б — на В и т.

Например, если исходной была цепочка КОТ, то результатом работы алгоритма будет цепочка ЛПУО, а если исходной была цепочка АУ, то результатом работы алгоритма будет цепочка БШФ.

Дана цепочка символов ВАТА. Какая цепочка символов получится, если к данной цепочке применить описанный алгоритм дважды (т. е. применить алгоритм к данной цепочке, а затем к результату вновь применить алгоритм)?

Русский алфавит: АБВГДЕЁЖЗИЙКЛМНОПРСТУФХЦЧШЩЪЫЬЭЮЯ

6

6

Некоторый алгоритм из одной цепочки символов получает новую цепочку следующим образом. Сначала вычисляется длина исходной цепочки символов; если она чётна, то в середину цепочки символов добавляется символ

д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.

д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.Например, если исходной была цепочка ВРМ, то результатом работы алгоритма будет цепочка ГСНА, а если исходной была цепочка

Дана цепочка символов КЛОН. Какая цепочка символов получится, если к данной цепочке применить описанный алгоритм дважды (т. е. применить алгоритм к данной цепочке, а затем к результату вновь применить алгоритм)?

Русский алфавит: АБВГДЕЁЖЗИЙКЛМНОПРСТУФХЦЧШЩЪЫЬЭЮЯ

7

7

Некоторый алгоритм из одной цепочки символов получает новую цепочку следующим образом. Сначала вычисляется длина исходной цепочки символов; если она чётна, то в середину цепочки символов добавляется символ А, а если нечётна, то из цепочки удаляется символ, стоящий в её середине. В полученной цепочке символов каждая буква заменяется буквой, следующей за ней в русском алфавите (

д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.

д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.Например, если исходной была цепочка МАК, то результатом работы алгоритма будет цепочка НЛ, а если исходной была цепочка ЗОЛА, то результатом работы алгоритма будет цепочка ИПБМБ.

Дана цепочка символов САНКИ. Какая цепочка символов получится, если к данной цепочке применить описанный алгоритм дважды (т. е. применить алгоритм к данной цепочке, а затем к результату вновь применить алгоритм)?

Русский алфавит: АБВГДЕЁЖЗИЙКЛМНОПРСТУФХЦЧШЩЪЫЬЭЮЯ

8

8

Некоторый алгоритм из одной цепочки символов получает новую цепочку следующим образом. Сначала вычисляется длина исходной цепочки символов; если она четна, то в середину цепочки символов добавляется символ А, а если нечетна, то в конец цепочки добавляется символ Я. В полученной цепочке символов каждая буква заменяется буквой, следующей за ней в русском алфавите (А — на Б, Б — на В и т.

Например, если исходной была цепочка ВРМ, то результатом работы алгоритма будет цепочка ГСНА, а если исходной была цепочка ПД, то результатом работы алгоритма будет цепочка РБЕ.

Дана цепочка символов СОК. Какая цепочка символов получится, если к данной цепочке применить описанный алгоритм дважды (т.е. применить алгоритм к данной цепочке, а затем к результату вновь применить алгоритм)?

Русский алфавит: АБВГДЕЕЖЗИЙКЛМНОПРСТУФХЦЧШЩЪЫЬЭЮЯ

9

9

Автомат получает на вход трёхзначное десятичное число. По полученному числу строится новое десятичное число по следующим правилам.

1. Вычисляются два числа – сумма старшего и среднего разрядов, а также сумма среднего и младшего разрядов заданного числа.

2. Полученные два числа записываются друг за другом в порядке невозрастания (без разделителей).

Пример. Исходное число: 277. Поразрядные суммы: 9, 14. Результат: 149.

Определите, сколько из приведённых ниже чисел могут получиться в результате работы автомата.

1616 169 163 1916 1619 316 916 116

В ответе запишите только количество чисел.

10

10

Автомат получает на вход четырёхзначное десятичное число. По полученному числу строится новое десятичное число по следующим правилам.

1. Вычисляются два числа — сумма всех цифр и произведение всех цифр исходного числа.

2. Полученные два числа записываются друг за другом в порядке невозрастания (без разделителей).

Пример. Исходное число: 7712. Поразрядные суммы: 17, 98. Результат: 9817.

Определите, сколько из приведённых ниже чисел не могут получиться в результате работы автомата.

58 87 124 250 411 1711 656136 841421

В ответе запишите только количество чисел.

| № | Ваш ответ | Правильный ответ |

Здесь появится результат тестовой части. Нажмите на кнопку «Завершить работу», чтобы увидеть правильные ответы. |

|---|

Алгоритм, записанный на естественном языке, обрабатывающий цепочки символов или списки

Ученикам > подготовка к ОГЭ > Алгоритм, записанный на естественном языке, обрабатывающий цепочки символов или списки

|

Введение в обработку текста на естественном языке | Венцислав Йорданов

Источник иконок: https://iconfinder.com После прочтения этого поста в блоге вы узнаете некоторые основные методы извлечения функций из и некоторых текста , поэтому вы можете использовать эти функции в качестве ввода для модели машинного обучения .

НЛП — это раздел информатики и искусственного интеллекта, связанный с взаимодействием между компьютерами и человеческими (естественными) языками. Используется для нанесения машинное обучение алгоритмы на текст и речь .

Например, мы можем использовать НЛП для создания таких систем, как распознавание речи , обобщение документов , машинный перевод , обнаружение спама , распознавание именованных сущностей , ответы на вопросы, автозаполнение, 9004 типизация и т.д. на.

В настоящее время у большинства из нас есть смартфоны с функцией распознавания речи. Эти смартфоны используют НЛП, чтобы понять, о чем идет речь. Также многие используют ноутбуки, операционная система которых имеет встроенное распознавание речи.

Некоторые примеры

Cortana

Источник: https://blogs. technet.microsoft.com/microsoft_presse/auf-diesen-4-saeulen-basiert-cortanas-persoenlichkeit/

technet.microsoft.com/microsoft_presse/auf-diesen-4-saeulen-basiert-cortanas-persoenlichkeit/В ОС Microsoft есть виртуальный помощник по имени Cortana , которая может распознавать естественный голос . Вы можете использовать его для настройки напоминаний, открытия приложений, отправки электронных писем, игр, отслеживания рейсов и посылок, проверки погоды и так далее.

Подробнее о командах Cortana можно прочитать здесь.

Siri

Источник: https://www.analyticsindiamag.com/behind-hello-siri-how-apples-ai-powered-personal-assistant-uses-dnn/ Siri — виртуальный помощник Apple Inc. . в операционных системах iOS, watchOS, macOS, HomePod и tvOS. Опять же, вы можете делать многое с помощью голосовых команд : начать звонок, написать кому-нибудь, отправить электронное письмо, установить таймер, сделать снимок, открыть приложение, установить будильник, использовать навигацию и так далее.

Вот полный список всех команд Siri.

Gmail

Источник: https://i.gifer.com/Ou1t.gifЗнаменитый почтовый сервис Gmail , разработанный Google, использует обнаружение спама для фильтрации спама.

NLTK ( Natural Language Toolkit ) — это ведущая платформа для создания программ Python для работы с данными человеческого языка . Он предоставляет простые в использовании интерфейсы для многих корпусов и лексических ресурсов . Кроме того, он содержит набор из библиотеки обработки текста для классификации, токенизации, выделения корней, тегов, синтаксического анализа и семантических рассуждений. Лучше всего то, что NLTK — это бесплатный проект с открытым исходным кодом, управляемый сообществом.

Мы воспользуемся этим набором инструментов, чтобы показать некоторые основы области обработки естественного языка. Для приведенных ниже примеров я предполагаю, что мы импортировали набор инструментов NLTK. Мы можем сделать это так:

Для приведенных ниже примеров я предполагаю, что мы импортировали набор инструментов NLTK. Мы можем сделать это так: import nltk .

В этой статье мы рассмотрим следующие темы:

- Sentence Tokenization

- Word Tokenization

- Text Lemmatization and Stemming

- Stop Words

- Regex

- Bag-of-Words

- TF-IDF

1. Sentence Tokenization

Sentence tokenization (also called sentence segmentation ) представляет собой задачу о делении строки письменного языка на ее составляющие предложения . Идея здесь выглядит очень простой. В английском и некоторых других языках мы можем разбивать предложения всякий раз, когда видим знак препинания.

Однако даже в английском языке эта проблема нетривиальна из-за использования точки для аббревиатур. При обработке простого текста таблицы сокращений, содержащие точки, могут помочь нам предотвратить неправильное назначение границ предложений . Во многих случаях мы используем библиотеки, чтобы сделать эту работу за нас, так что пока не беспокойтесь о деталях.

Во многих случаях мы используем библиотеки, чтобы сделать эту работу за нас, так что пока не беспокойтесь о деталях.

Пример :

Давайте посмотрим текст об известной настольной игре под названием нарды.

Нарды — одна из старейших известных настольных игр. Его историю можно проследить почти на 5000 лет до археологических открытий на Ближнем Востоке. Это игра для двух игроков, в которой у каждого игрока есть пятнадцать шашек, которые перемещаются между двадцатью четырьмя точками в соответствии с броском двух игральных костей.

Чтобы применить токенизацию предложений с помощью NLTK, мы можем использовать функцию nltk.sent_tokenize .

На выходе получаем 3 составных предложения по отдельности.

Нарды — одна из старейших известных настольных игр.Его история насчитывает почти 5000 лет, начиная с археологических открытий на Ближнем Востоке.

Это игра для двух игроков, в которой у каждого игрока есть пятнадцать шашек, которые перемещаются между двадцатью четырьмя точками в соответствии с броском двух костей.

2. Токенизация слов

Токенизация слов (также называемая сегментацией слов ) — это проблема деления строки письменного языка на его компонент слова . В английском и многих других языках, использующих ту или иную форму латинского алфавита, пробел является хорошим приближением к разделителю слов.

Тем не менее, у нас все еще могут быть проблемы, если мы разделяем только по пробелу для достижения желаемых результатов. Некоторые английские составные существительные пишутся по-разному и иногда содержат пробел. В большинстве случаев мы используем библиотеку для достижения желаемых результатов, так что не беспокойтесь о деталях.

Пример :

Давайте воспользуемся предложениями из предыдущего шага и посмотрим, как мы можем применить к ним токенизацию слов. Мы можем использовать функцию nltk.word_tokenize .

Вывод:

['Нарды', 'есть', 'один', 'из', 'самый старый', 'известный', 'доска', 'игры', '.']

[' Его», «история», «может», «быть», «прослеживаться», «назад», «почти», «5000», «лет», «до», «археологический», «открытия», «в» , 'the', 'Ближний', 'Восток', '.']

['Это', 'есть', 'а', 'два', 'игрок', 'игра', 'где', 'каждый ', 'игрок', 'имеет', 'пятнадцать', 'шашки', 'которые', 'ход', 'между', 'двадцать четыре', 'точки', 'согласно', 'к', 'точка ', 'бросок', 'из', 'два', 'кости', '.']

Лемматизация текста и выделение корней

По грамматическим причинам документы могут содержать различных формы слова , например привод , привод , привод . Кроме того, иногда у нас есть связанных слова с похожим значением, например, нация , национальный , национальность .

Цель как выведения , так и лемматизации состоит в том, чтобы уменьшить флективный образует и иногда деривационные формы от слова до общей базовой формы .

Источник: https://nlp.stanford.edu/IR-book/html/htmledition/stemming-and-lemmatization-1.html be

=> собакаРезультат применения этого сопоставления к тексту будет примерно таким:

- собаки мальчика разного размера

=>собака мальчика разного размера

Стемминг и лемматизация являются частными случаями нормализации . Однако они отличаются друг от друга.

Stemming обычно относится к грубому эвристическому процессу , который отсекает концы слов в надежде на правильное достижение этой цели в большинстве случаев и часто включает удаление производных аффиксов.

Лемматизация обычно относится к правильным действиям с использованием словаря и морфологического анализа слов, обычно направленного на удаление только флективных окончаний и возвращение базовой или словарной формы слова, которая известная как лемма .

Источник: https://nlp.stanford.edu/IR-book/html/htmledition/stemming-and-lemmatization-1.html

Разница в том, что стеммер оперирует без знания контекста и, следовательно, не может понять разницу между словами, которые имеют разное значение в зависимости от части речи. Но стеммеры также имеют некоторые преимущества, они проще в реализации и обычно работают быстрее . Кроме того, пониженная «точность» может не иметь значения для некоторых приложений.

Примеры:

- Лемма слова «лучше» содержит «хорошо». Эта ссылка пропускается при поиске по основам, так как требует поиска в словаре.

- Слово «играть» является базовой формой слова «играть», и, следовательно, оно совпадает как в корневой, так и в лемматизации.

- Слово «встреча» может быть либо основной формой существительного, либо формой глагола («встречаться») в зависимости от контекста; например, «на нашей последней встрече» или «Мы снова встречаемся завтра».

В отличие от стемминга, лемматизация пытается выбрать правильную лемму в зависимости от контекста.

В отличие от стемминга, лемматизация пытается выбрать правильную лемму в зависимости от контекста.

После того, как мы узнали, в чем разница, давайте рассмотрим несколько примеров с использованием инструмента NLTK.

Вывод:

Стеммер: видел

Лемматизатор: см.Стеммер: привод

Лемматизатор: привод

Стоп-слова

Источник: http://www.nepalinlp.com/detail/stop-words-removal_nepali/Стоп-слова это слова, которые отфильтрованы до или после обработки текста. При применении машинного обучения к тексту эти слова могут добавить много шума . Вот почему мы хотим удалить эти нерелевантных слова .

Стоп-слова обычно относятся к наиболее распространенным словам , таким как « и », « », « a » в языке, но не существует единого универсального списка стоп-слов. Список стоп-слов может меняться в зависимости от вашего приложения.

Инструмент NLTK имеет предопределенный список стоп-слов, который относится к наиболее распространенным словам. Если вы используете его впервые, вам необходимо загрузить стоп-слова, используя этот код: nltk.download («стоп-слова») . После завершения загрузки мы можем загрузить пакет стоп-слов из nltk.corpus и использовать его для загрузки стоп-слов.

Вывод:

['я', 'я', 'мой', 'я', 'мы', 'наш', 'наш', 'нас', 'ты', 'ты', " у вас есть», «вы будете», «вы бы», «ваш», «ваш», «себя», «себя», «он», «его», «его», «сам», « она', «она», «ее», «ее», «сама», «это», «это», «это», «сама», «они», «их», «их», «их» , 'себя', 'что', 'который', 'кто', 'кому', 'этот', 'тот', 'этот', 'эти', 'те', 'есть', 'есть' , 'есть', 'был', 'были', 'быть', 'был', 'быть', 'иметь', 'имеет', 'иметь', 'иметь', 'делать', 'делает', ' сделал», «делает», «а», «а», «то», «и», «но», «если», «или», «потому что», «как», «до», «пока» , 'из', 'в', 'по', 'за', 'с', 'о', 'против', 'между', 'в', 'сквозь', 'во время', 'до', ' после», «выше», «ниже», «до», «от», «вверх», «вниз», «в», «вне», «вкл», «выкл», «над», «под» , 'снова', 'далее', 'тогда', 'один раз', 'здесь', 'там', 'когда', 'где', 'почему', 'как', 'все', 'каждый', ' оба», «каждый», «несколько», «больше», «большинство», «другой», «некоторые», «такой», «нет», «ни», «не», «только».у', 'собственный', 'такой же', 'так', 'чем', 'тоже', 'очень', 'с', 'т', 'может', 'будет', 'просто', 'дон' , «не», «должен», «должен был», «сейчас», «д», «лл», «м», «о», «ре», «ве», «у», «у». ain', 'арен', "не", 'могл', "не мог", 'делал', "не делал", 'не делает', 'не имел', 'имел' т», «имеет», «не имеет», «убежище», «не имеет», «есть», «не является», «ма», «может», «не может», «должен» , «не должен», «нужен», «не должен», «шань», «не должен», «должен», «не должен», «был», «не был», «были» , «не было», «выиграл», «не будет», «будет», «не будет»]

Давайте посмотрим, как мы можем удалить стоп-слова из предложения.

Выходные данные:

['Нарды', 'один', 'самый старый', 'известный', 'доска', 'игры', '.']

Если вы не знакомы со списком понятий в Питон. Вот еще один способ добиться того же результата.

Тем не менее, имейте в виду, что обработки списков быстрее , потому что они оптимизированы для того, чтобы интерпретатор Python обнаруживал предсказуемый шаблон во время цикла.

Вы можете задаться вопросом, почему мы конвертируем наш список в набор . Набор — это абстрактный тип данных, который может хранить уникальные значения без какого-либо определенного порядка. операция поиска в наборе намного быстрее чем операция поиска в списке . Для небольшого количества слов большой разницы нет, но если у вас большое количество слов, настоятельно рекомендуется использовать тип набора.

Если вы хотите узнать больше о времени, которое уходит между различными операциями для разных структур данных, вы можете посмотреть эту замечательную шпаргалку.

Регулярное выражение

Источник: https://digitalfortress.tech/tricks/top-15-commonly-used-regex/ Регулярное выражение , регулярное выражение или регулярное выражение — это последовательность символов, определяющая поисковый шаблон . Давайте посмотрим на некоторые основы.

Давайте посмотрим на некоторые основы.

-

.— соответствует любому символу кроме новой строки -

\w— соответствует слову -

\d— соответствует цифре 9 ABC] — Не Матч A, B, или C -

[A - G]— Матч A символ между A & G

Обычные экспрессии Используйте Backslash. ‘\’ ) для обозначения специальных форм или для разрешения использования специальных символов без обращения к их особому значению. Этот конфликтует с использованием Python того же символа для той же цели в строковых литералах; например, чтобы соответствовать буквальному обратному слэшу, может потребоваться написать

'\\\\'в качестве строки шаблона, потому что регулярное выражение должно быть\\, а каждая обратная косая черта должна быть выражена как\\внутри обычного строкового литерала Python.Решение состоит в том, чтобы использовать нотацию необработанных строк Python для шаблонов регулярных выражений; обратная косая черта не обрабатывается каким-либо особым образом в строковом литерале с префиксом

'r'. Итак,r"\n"— это двухсимвольная строка, содержащая'\'и'n', а"\n"— это односимвольная строка, содержащая новую строку. Обычно шаблоны будут выражены в коде Python с использованием этой записи необработанных строк.

Источник: https://docs.python.org/3/library/re.html?highlight=regex

Мы можем использовать регулярное выражение, чтобы применить дополнительную фильтрацию к нашему тексту. Например, мы можем удалить все символы, не являющиеся словами. Во многих случаях нам не нужны знаки препинания, и их легко удалить с помощью регулярных выражений.

В Python модуль re обеспечивает операции сопоставления с регулярными выражениями, аналогичные тем, которые используются в Perl. Мы можем использовать функцию

Мы можем использовать функцию re.sub , чтобы заменить совпадения шаблона строкой замены. Давайте посмотрим на пример, когда мы заменяем все не-слова символом пробела.

Результат:

'Развитие сноуборда было вдохновлено катанием на скейтборде, санях, серфинге и катании на лыжах'

Регулярное выражение является мощным инструментом, и мы можем создавать гораздо более сложные шаблоны. Если вы хотите узнать больше о регулярных выражениях, я могу порекомендовать вам попробовать эти 2 веб-приложения: regexr, regex101.

Мешок слов

Источник: https://www.iconfinder.com/icons/299088/bag_iconАлгоритмы машинного обучения не могут напрямую работать с необработанным текстом, нам нужно преобразовать текст в векторы чисел. Это называется извлечением признаков .

Модель набор слов представляет собой популярную и простую технику извлечения признаков , используемую при работе с текстом. Он описывает появление каждого слова в документе.

Он описывает появление каждого слова в документе.

Чтобы использовать эту модель, нам необходимо:

- Разработать словарь известных слов (также называемых токенами )

- Выбрать меру присутствия известных слов

Любую информацию о порядке или структура слов отбрасывается . Вот почему его называют мешком слов. Эта модель пытается понять, встречается ли известное слово в документе, но не знает, где это слово в документе.

Интуиция такова, что похожих документа имеют похожее содержание . Кроме того, из содержания мы можем кое-что узнать о значении документа.

Пример Давайте посмотрим, какие шаги нужно выполнить для создания модели «мешок слов». В этом примере мы будем использовать только четыре предложения, чтобы увидеть, как работает эта модель. В реальных задачах вы будете работать с гораздо большими объемами данных.

В реальных задачах вы будете работать с гораздо большими объемами данных.

1. Загрузите данные

Источник: https://www.iconfinder.com/icons/315166/note_text_iconДопустим, это наши данные и мы хотим загрузить их в виде массива.

Для этого мы можем просто прочитать файл и разбить его по строкам.

Результат:

["Мне нравится этот фильм, он смешной", "Я ненавижу этот фильм", "Это было потрясающе! Мне это нравится.», «Хороший. Мне это нравится.']

2. Дизайн словаря

Источник: https://www.iconfinder.com/icons/2109153/book_contact_dairy_google_service_iconДавайте получим все уникальные слова из четырех загруженных предложений, игнорируя регистр , пунктуация и односимвольные токены. Эти слова и будут нашим словарным запасом (известными словами).

Мы можем использовать класс CountVectorizer из библиотеки sklearn для разработки нашего словаря. Мы увидим, как мы можем использовать его после прочтения следующего шага.

3. Создайте векторы документа

Источник: https://www.iconfinder.com/icons/1574/binary_iconДалее нам нужно оценить слова в каждом документе. Задача здесь состоит в том, чтобы преобразовать каждый необработанный текст в вектор чисел. После этого мы можем использовать эти векторы в качестве входных данных для модели машинного обучения. Самый простой метод подсчета очков — отметить наличие слов 1 для наличия и 0 для отсутствия.

Теперь давайте посмотрим, как мы можем создать модель мешка слов, используя упомянутый выше класс CountVectorizer.

Вывод :

Вот наши предложения. Теперь мы можем увидеть, как работает модель мешка слов.

Дополнительные примечания к модели «мешка слов»

Источник: https://www.iconfinder.com/icons/1118207/clipboard_notes_pen_pencil_iconизвестных слов (токенов) и как оценка наличия известных слов.

Проектирование словаря

Когда размер словаря увеличивается , векторное представление документов также увеличивается. В приведенном выше примере длина вектора документа равна количеству известных слов.

В приведенном выше примере длина вектора документа равна количеству известных слов.

В некоторых случаях у нас может быть огромное количество данных , и в этом случае длина вектора, представляющего документ, может составлять тысяч или миллионов элементов. Кроме того, каждый документ может содержать лишь некоторые из известных слов в словаре.

Следовательно, векторные представления будут иметь лота нулей . Эти векторы, которые имеют много нулей, называются разреженными векторами . Они требуют больше памяти и вычислительных ресурсов.

Мы можем уменьшить количество известных слов при использовании модели мешка слов для уменьшения требуемой памяти и вычислительных ресурсов. Мы можем использовать техники очистки текста мы уже видели в этой статье, прежде чем создавать нашу модель мешка слов:

- Игнорирование регистра слов

- Игнорирование пунктуации

- Удаление стоп-слов из 4 наших документов 9000

- Приведение слов к их базовой форме ( Лемматизация текста и выделение корней )

- Исправление слов с ошибками

Еще один более сложный способ создания словаря — использование сгруппированных слов . Это изменяет объем словаря и позволяет модели набора слов получить дополнительные сведения о документе. Этот подход называется n-грамм .

Это изменяет объем словаря и позволяет модели набора слов получить дополнительные сведения о документе. Этот подход называется n-грамм .

N-грамма представляет собой последовательность из числа из элементов (слова, буквы, числа, цифры и т. д.). В контексте текстовых корпусов n-граммы обычно относятся к последовательности слов. Униграмма — одно слово, биграмма — последовательность из двух слов, триграмма — это последовательность из трех слов и т. д. «n» в «n-грамме» означает количество сгруппированных слов. Моделируются только те n-граммы, которые появляются в корпусе, а не все возможные n-граммы.

Пример

Давайте посмотрим на All Bigrams для следующего предложения:

Офисное здание открыто сегодня

Все биграмс:

- Офис

- Офис.

- открыто сегодня

Метод мешков биграмм более эффективен, чем метод мешков слов.

Оценка слов

После того, как мы создали наш словарь известных слов, нам нужно оценить встречаемость слов в наших данных. Мы видели один очень простой подход — бинарный подход (1 — наличие, 0 — отсутствие).

Некоторые дополнительные методы оценки:

- Подсчет . Подсчитайте, сколько раз каждое слово появляется в документе.

- Частоты . Вычислите частоту появления каждого слова в документе среди всех слов в документе.

TF-IDF

Одна из проблем с оценкой частоты слов заключается в том, что наиболее часто встречающиеся слова в документе начинают иметь самые высокие оценки. Эти частые слова могут не содержать столько « информационного прироста » по сравнению с некоторыми более редкими и специфичными для предметной области словами. Один из подходов к решению этой проблемы — оштрафовать 9.0004 слова, которые встречаются во всех документах . Этот подход называется TF-IDF.

Этот подход называется TF-IDF.

TF-IDF, сокращение от термина , частота документа, обратная частоте , — это статистическая мера , используемая для оценки важности слова в документе в коллекции или корпусе.

Значение оценки TF-IDF увеличивается пропорционально количеству раз, которое слово появляется в документе, но компенсируется количеством документов в корпусе, содержащих это слово.

Давайте посмотрим на формулу, используемую для расчета оценки TF-IDF для заданного термина x в документе y .

Формула TF-IDF. Источник: http://filotechnologia.blogspot.com/2014/01/a-simple-java-class-for-tfidf-scoring.htmlТеперь давайте немного разделим эту формулу и посмотрим, как различные части формулы работа.

- Частота термина (TF) : оценка частоты слова в текущем документе.

- Обратная частота терминов (ITF) : оценка того, насколько редко слово встречается в документах.

- Наконец, мы можем использовать предыдущие формулы для расчета оценки TF-IDF для заданного термина следующим образом:

Пример

Класс TfidfVectorizer из библиотеки sklearn для расчета оценок TF-IDF для заданных документов. Давайте воспользуемся теми же предложениями, что и в примере с мешком слов.

Вывод:

Опять же, я добавлю сюда предложения для удобства сравнения и лучшего понимания того, как работает этот подход.

В этом сообщении блога вы узнаете основы НЛП для текста. В частности, вы изучили следующие понятия с дополнительными подробностями:

- NLP используется для применения алгоритмов машинного обучения до текста и речи .

- NLTK ( Инструментарий естественного языка ) является ведущей платформой для создания программ на Python для работы с данными человеческого языка

- Токенизация предложений является проблемой деления строки письменного языка на ее компонент 03

3 слов

3 предложений

3

— это проблема деления строки письменного языка на ее составные части слов4 токенизация

- Цель обоих основ и лемматизация означает сокращение флективных форм и иногда производных форм слова до общей базовой формы .

- Стоп-слова — это слова, которые отфильтровываются до или после обработки текста. Они обычно относятся к наиболее распространенным словам в языке.

- Регулярное выражение представляет собой последовательность символов, определяющую шаблон поиска .

- Модель мешка слов представляет собой популярную и простую технику извлечения признаков , используемую при работе с текстом. Он описывает появление каждого слова в документе.

- TF-IDF — это статистическая мера , используемая для оценки важности слова для документа в коллекции или корпусе.

Потрясающе! Теперь мы знаем основы того, как извлекать признаки из текста. Затем мы можем использовать эти функции в качестве входных данных для алгоритмов машинного обучения.

Хотите увидеть все концепции используемые в еще один большой пример ?

— Вот ты где! Если вы читаете с мобильного устройства, прокрутите вниз до конца и нажмите ссылку « Desktop version ».

- https://en.wikipedia.org/wiki/Natural_language_processing

- http://www.nltk.org/

- https://en.wikipedia.org/wiki/Text_segmentation

- https://en .wikipedia.org/wiki/Лемматизация

- https://en.wikipedia.org/wiki/Stemming

- https://nlp.stanford.edu/IR-book/html/htmledition/stemming-and-lemmatization-1.html

- https://en.wikipedia.org/wiki/Stop_words

- https:// en.wikipedia.org/wiki/Regular_expression

- https://docs.python.org/3/library/re.html?highlight=regex

- https://machinelearningmastery.com/gentle-introduction-bag-words- модель/

- https://chrisalbon.com/machine_learning/preprocessing_text/bag_of_words/

- https://en.wikipedia.org/wiki/Tf%E2%80%93idf

Вот интерактивная версия этой статьи, загруженная в Deepnote (облачная платформа Jupyter Notebook). Не стесняйтесь проверить это и поиграть с примерами.

Не стесняйтесь проверить это и поиграть с примерами.

Вы также можете проверить мои предыдущие сообщения в блоге.

- Ярлыки Jupyter Notebook

- Python Basics for Data Science

- Data Science with Python: Intro to Data Visualization with Matplotlib

- Data Science with Python: Intro to Loading, Subsetting, and Filtering Data with pandas

Если вы хотите получать уведомления, когда я публикую новую запись в блоге, вы можете подписаться на мою свежую рассылку.

Вот мой профиль LinkedIn на случай, если вы захотите связаться со мной. Я буду счастлив быть связанным с вами.

Спасибо, что прочитали. Я надеюсь, что вам понравилась статья. Если вам это нравится, пожалуйста, удерживайте кнопку хлопка и поделитесь им с друзьями. Буду рад услышать ваши отзывы. Если у вас есть вопросы, не стесняйтесь задавать их. 😉

Ваше руководство по обработке естественного языка (NLP) | Диего Лопес Исэ

Как машины обрабатывают и понимают человеческий язык

Все, что мы выражаем (устно или письменно), несет в себе огромное количество информации. Тема, которую мы выбираем, наш тон, наш выбор слов, все добавляет некую информацию, которую можно интерпретировать и извлечь из нее ценность. Теоретически мы можем понять и даже предсказать поведение человека, используя эту информацию.

Тема, которую мы выбираем, наш тон, наш выбор слов, все добавляет некую информацию, которую можно интерпретировать и извлечь из нее ценность. Теоретически мы можем понять и даже предсказать поведение человека, используя эту информацию.

Но есть проблема: один человек может сгенерировать сотни или тысячи слов в объявлении, каждое предложение соответствующей сложности. Если вы хотите масштабировать и анализировать несколько сотен, тысяч или миллионов людей или деклараций в заданной географии, то ситуация неуправляемая.

Данные, полученные из разговоров, заявлений или даже твитов, являются примерами неструктурированных данных. Неструктурированные данные не вписываются в традиционную структуру строк и столбцов реляционных баз данных и представляют подавляющее большинство данных, доступных в реальном мире. Это грязно и трудно манипулировать. Тем не менее, благодаря достижениям в таких дисциплинах, как машинное обучение, в этой теме происходит большая революция. В настоящее время речь идет уже не о попытках интерпретировать текст или речь на основе ключевых слов (старомодный механический способ), а о понимании смысла этих слов (когнитивный способ). Таким образом можно обнаружить фигуры речи, такие как ирония, или даже выполнить анализ настроений.

В настоящее время речь идет уже не о попытках интерпретировать текст или речь на основе ключевых слов (старомодный механический способ), а о понимании смысла этих слов (когнитивный способ). Таким образом можно обнаружить фигуры речи, такие как ирония, или даже выполнить анализ настроений.

Обработка естественного языка или НЛП — это область искусственного интеллекта, которая дает машинам возможность читать, понимать и извлекать смысл из человеческих языков.

Это дисциплина, которая фокусируется на взаимодействии между наукой о данных и человеческим языком и масштабируется во многих отраслях. Сегодня НЛП переживает бум благодаря огромным улучшениям в доступе к данным и увеличению вычислительной мощности, которые позволяют практикам достигать значимых результатов в таких областях, как здравоохранение, СМИ, финансы и человеческие ресурсы, среди прочих.

Проще говоря, НЛП представляет собой автоматическую обработку естественного человеческого языка, такого как речь или текст, и хотя сама концепция завораживает, реальная ценность этой технологии заключается в вариантах ее использования.

НЛП может помочь вам с множеством задач, и кажется, что области его применения только расширяются с каждым днем. Приведем несколько примеров:

- НЛП позволяет распознавать и прогнозировать заболевания на основе электронных медицинских карт и собственной речи пациента. Эта способность исследуется при состояниях здоровья, которые варьируются от сердечно-сосудистых заболеваний до депрессии и даже шизофрении. Например, Amazon Comprehend Medical — это сервис, который использует НЛП для извлечения данных о заболеваниях, лекарствах и результатах лечения из историй болезни, отчетов о клинических испытаниях и других электронных медицинских карт.

- Организации могут определить, что клиенты говорят об услуге или продукте, идентифицируя и извлекая информацию из таких источников, как социальные сети. Этот анализ настроений может предоставить много информации о выборе клиентов и их факторах принятия решений.

- Изобретатель из IBM разработал когнитивный помощник , который работает как персонализированная поисковая система, изучая все о вас, а затем напоминая вам об имени, песне или о чем-либо, что вы не можете вспомнить, в тот момент, когда вам это нужно.

- Такие компании, как Yahoo и Google, фильтруют и классифицируют ваши электронные письма с помощью NLP, анализируя текст в электронных письмах, которые проходят через их серверы, и останавливая спам еще до того, как они попадут в ваш почтовый ящик.

- Чтобы помочь идентифицировать фальшивые новости , группа НЛП в Массачусетском технологическом институте разработала новую систему для определения того, является ли источник точным или политически предвзятым, определяя, можно ли доверять источнику новостей или нет.

- Alexa от Amazon и Siri от Apple являются примерами интеллектуальных голосовых интерфейсов , которые используют НЛП, чтобы реагировать на голосовые подсказки и делать все, например, находить конкретный магазин, сообщать нам прогноз погоды, предлагать лучший маршрут до офиса или включать свет дома.

- Понимание того, что происходит и о чем говорят люди, может быть очень ценным для финансовых трейдеров .

NLP используется для отслеживания новостей, отчетов, комментариев о возможных слияниях между компаниями, затем все это может быть включено в торговый алгоритм для получения огромной прибыли. Помните: покупайте слухи, продавайте новости.

NLP используется для отслеживания новостей, отчетов, комментариев о возможных слияниях между компаниями, затем все это может быть включено в торговый алгоритм для получения огромной прибыли. Помните: покупайте слухи, продавайте новости. - НЛП также используется как на этапах поиска, так и на этапах отбора набора талантов , определяя навыки потенциальных сотрудников, а также выявляя потенциальных кандидатов до того, как они станут активными на рынке труда.

- На базе технологии IBM Watson NLP компания LegalMation разработала платформу для автоматизации рутинных судебных задач и помогает юридическим командам экономить время, снижать расходы и менять стратегический фокус.

НЛП особенно быстро развивается в сфере здравоохранения . Эта технология улучшает оказание медицинской помощи, диагностику заболеваний и снижает затраты, в то время как организации здравоохранения все чаще внедряют электронные медицинские карты. Тот факт, что клиническая документация может быть улучшена, означает, что пациенты могут быть лучше поняты и получать пользу благодаря более качественному медицинскому обслуживанию. Целью должна быть оптимизация их опыта, и несколько организаций уже работают над этим.

Тот факт, что клиническая документация может быть улучшена, означает, что пациенты могут быть лучше поняты и получать пользу благодаря более качественному медицинскому обслуживанию. Целью должна быть оптимизация их опыта, и несколько организаций уже работают над этим.

Такие компании, как Winterlight Labs, добились огромных успехов в лечении болезни Альцгеймера, отслеживая когнитивные нарушения с помощью речи, и они также могут поддерживать клинические испытания и исследования для широкого спектра центральных расстройства нервной системы. Следуя аналогичному подходу, Стэнфордский университет разработал Woebot, чат-бота-терапевта , с целью помочь людям с тревогой и другими расстройствами.

Но вокруг этого предмета идут серьезные споры. Пару лет назад Microsoft продемонстрировала, что, анализируя большие выборки поисковых запросов, они могут идентифицировать интернет-пользователей, страдающих раком поджелудочной железы, еще до того, как им был поставлен диагноз этого заболевания. Как пользователи отреагируют на такой диагноз? И что произойдет, если ваш тест окажется ложноположительным? (это означает, что у вас может быть диагностировано заболевание, даже если у вас его нет). Это напоминает случай с Google Flu Trends, который в 2009 г.было объявлено, что оно может предсказывать грипп, но позже исчезло из-за его низкой точности и неспособности соответствовать прогнозируемым показателям.

Как пользователи отреагируют на такой диагноз? И что произойдет, если ваш тест окажется ложноположительным? (это означает, что у вас может быть диагностировано заболевание, даже если у вас его нет). Это напоминает случай с Google Flu Trends, который в 2009 г.было объявлено, что оно может предсказывать грипп, но позже исчезло из-за его низкой точности и неспособности соответствовать прогнозируемым показателям.

НЛП может стать ключом к эффективной клинической поддержке в будущем, но в краткосрочной перспективе предстоит решить еще много проблем.

Основные недостатки НЛП, с которыми мы сталкиваемся в наши дни, связаны с тем фактом, что язык очень сложен. Процесс понимания и манипулирования языком чрезвычайно сложен, и по этой причине обычно используются разные методы для решения разных задач, прежде чем связать все воедино. Языки программирования, такие как Python или R, широко используются для выполнения этих методов, но прежде чем углубляться в строки кода (это будет темой другой статьи), важно понять концепции, лежащие в их основе. Подытожим и объясним некоторые из наиболее часто используемых алгоритмов НЛП при определении словарного запаса терминов:

Подытожим и объясним некоторые из наиболее часто используемых алгоритмов НЛП при определении словарного запаса терминов:

Широко используемая модель, позволяющая подсчитывать все слова в фрагменте текста. По сути, он создает матрицу вхождений для предложения или документа, игнорируя грамматику и порядок слов. Эти частоты или вхождения слов затем используются в качестве признаков для обучения классификатора.

Для краткого примера я взял первое предложение песни «Across the Universe» группы The Beatles:

Слова текут бесконечным дождем в бумажный стаканчик,

Они скользят во время прохождения, они ускользают через вселенную

Теперь давайте посчитаем слова:

Этот подход может отражать несколько недостатков, таких как отсутствие семантического значения и контекста, а также факты, которые останавливают слова (например, » или «a») добавляют шум в анализ, а некоторые слова не имеют соответствующего веса («вселенная» имеет меньший вес, чем слово «они»).

Чтобы решить эту проблему, один из подходов состоит в том, чтобы перемасштабировать частоту слов по частоте их появления во всех текстах (а не только в том, который мы анализируем), чтобы баллы за часто встречающиеся слова, такие как «the», которые также часто другие тексты, получить штраф. Такой подход к подсчету очков называется «Частота термина — обратная частота документа» (TFIDF) и улучшает набор слов по весам. С помощью TFIDF частые термины в тексте «вознаграждаются» (например, слово «они» в нашем примере), но они также «наказываются», если эти термины часто встречаются в других текстах, которые мы также включаем в алгоритм. Наоборот, этот метод выделяет и «вознаграждает» уникальные или редкие термины с учетом всех текстов. Тем не менее, этот подход по-прежнему не имеет ни контекста, ни семантики.

Токенизация Процесс сегментации бегущего текста на предложения и слова. По сути, это задача разрезать текст на части, называемые токенами , и в то же время отбрасывать определенные символы, например знаки препинания. Следуя нашему примеру, результатом токенизации будет:

Следуя нашему примеру, результатом токенизации будет:

Довольно просто, правда? Что ж, хотя в этом случае, а также в таких языках, как английский, может показаться довольно простым, что слова разделяются пробелом (так называемые сегментированные языки), не все языки ведут себя одинаково, и если подумать, одних пробелов недостаточно. даже для английского языка для выполнения правильной токенизации. Разбиение на пробелы может разбить то, что следует рассматривать как один токен, как в случае с определенными именами (например, Сан-Франциско или Нью-Йорк) или заимствованными иностранными фразами (например, laissez faire).

Токенизация также может удалить пунктуацию , упрощая путь к правильной сегментации слов, но также вызывая возможные осложнения. В случае точек, следующих за аббревиатурой (например, dr.), точку, следующую за этой аббревиатурой, следует рассматривать как часть того же токена и не удалять.

Процесс токенизации может быть особенно проблематичным при работе с биомедицинскими текстовыми доменами, которые содержат много дефисов, скобок и других знаков препинания.

Более подробные сведения о токенизации можно найти в этой статье.

Удаление стоп-словВключает удаление общеупотребительных артиклей, местоимений и предлогов, таких как «and», «the» или «to» в английском языке. В этом процессе некоторые очень распространенные слова, которые, по-видимому, не представляют большой ценности для целей НЛП, фильтруются и исключаются из обрабатываемого текста, тем самым удаляя широко распространенные и часто встречающиеся термины, которые не несут информации о соответствующем тексте.

Стоп-слова можно безопасно игнорировать, выполнив поиск в предварительно определенном списке ключевых слов, освободив место в базе данных и сократив время обработки.

Универсального списка стоп-слов не существует. Они могут быть выбраны заранее или созданы с нуля. Потенциальный подход состоит в том, чтобы начать с принятия заранее определенных стоп-слов и позже добавить слова в список. Тем не менее, кажется, что в последнее время общая тенденция состояла в том, чтобы перейти от использования больших стандартных списков стоп-слов к полному отсутствию списков.

Дело в том, что удаление стоп-слов может стереть важную информацию и изменить контекст в заданном предложении. Например, если мы проводим анализ настроений, мы можем сбить наш алгоритм с пути, если удалим стоп-слово, например «не». В этих условиях вы можете выбрать минимальный список стоп-слов и добавить дополнительные термины в зависимости от вашей конкретной цели.

StemmingОтносится к процессу нарезки конца или начала слов с целью удаления аффиксов (лексических дополнений к корню слова).

Аффиксы, которые присоединяются к началу слова, называются префиксами (например, «астро» в слове «астробиология»), а те, которые присоединяются к концу слова, называются суффиксами (например, «фул» словом «полезно»).

Проблема в том, что аффиксы могут создавать или расширять новые формы одного и того же слова (называемые флективными аффиксами) или даже сами создавать новые слова (называемые производными аффиксами). В английском языке префиксы всегда являются словообразовательными (аффикс создает новое слово, как в примере с приставкой «эко» в слове «экосистема»), а вот суффиксы могут быть словообразовательными (аффикс создает новое слово, как в примере с приставкой «экосистема»). суффикс «ист» в слове «гитарист») или флективным (аффикс образует новую форму слова, как в примере суффикса «ер» в слове «быстрее»).

В английском языке префиксы всегда являются словообразовательными (аффикс создает новое слово, как в примере с приставкой «эко» в слове «экосистема»), а вот суффиксы могут быть словообразовательными (аффикс создает новое слово, как в примере с приставкой «экосистема»). суффикс «ист» в слове «гитарист») или флективным (аффикс образует новую форму слова, как в примере суффикса «ер» в слове «быстрее»).

Итак, как мы можем определить разницу и отрезать правильный бит?

Возможный подход состоит в том, чтобы рассмотреть список общих аффиксов и правил (языки Python и R имеют разные библиотеки, содержащие аффиксы и методы) и выполнить на их основе создание корней, но, конечно, этот подход имеет ограничения. Поскольку стеммеры используют алгоритмические подходы, результатом процесса стемминга может быть не фактическое слово или даже изменение значения слова (и предложения). Чтобы компенсировать этот эффект, вы можете редактировать эти предопределенные методы, добавляя или удаляя аффиксы и правила, но вы должны учитывать, что вы можете улучшить производительность в одной области, ухудшив другую. Всегда смотрите на картину в целом и проверяйте производительность вашей модели.

Всегда смотрите на картину в целом и проверяйте производительность вашей модели.

Итак, если стемминг имеет серьезные ограничения, почему мы его используем? Прежде всего, его можно использовать для исправления орфографических ошибок в токенах. Стеммеры просты в использовании и работают очень быстро (они выполняют простые операции над строкой), и если скорость и производительность важны в модели НЛП, то стеммеры, безусловно, лучший вариант. Помните, мы используем его с целью улучшения нашей работы, а не как упражнение по грамматике.

Лемматизация Имеет целью привести слово к его основной форме и сгруппировать различные формы одного и того же слова. Например, глаголы в прошедшем времени заменяются на настоящее (например, «пошел» заменяется на «идти»), а синонимы унифицируются (например, «лучший» заменяется на «хороший»), тем самым стандартизируя слова со значением, близким к их корню. Хотя лемматизация кажется тесно связанной с процессом образования корней, она использует другой подход для получения корневых форм слов.

Лемматизация преобразует слова в их словарную форму (известную как лемма ), для чего требуются подробные словари, в которых алгоритм может просматривать и связывать слова с соответствующими им леммами.

Например, слова « running», «runs» и «run» — все формы слова « run» , поэтому « run» — это лемма всех предыдущих слов.

Лемматизация также принимает во внимание контекст слова, чтобы решает другие проблемы, такие как устранение неоднозначности , что означает, что он может различать идентичные слова, которые имеют разные значения в зависимости от конкретного контекста. Подумайте о таких словах, как «летучая мышь» (которое может соответствовать животному или металлической/деревянной клюшке, используемой в бейсболе) или «банк» (соответствующее финансовому учреждению или земле рядом с водоемом). Предоставляя слову параметр части речи (будь то существительное, глагол и т. д.), можно определить роль этого слова в предложении и устранить неоднозначность.

д.), можно определить роль этого слова в предложении и устранить неоднозначность.

Как вы уже поняли, лемматизация — гораздо более ресурсоемкая задача, чем выполнение процесса стемминга. В то же время, поскольку для этого требуется больше знаний о структуре языка, чем для определения основы, требуется больше вычислительной мощности, чем для настройки или адаптации алгоритма основы.

Тематическое моделированиеЯвляется методом обнаружения скрытых структур в наборах текстов или документов. По сути, он группирует тексты для обнаружения скрытых тем на основе их содержания, обрабатывая отдельные слова и присваивая им значения на основе их распределения. Этот метод основан на предположении, что каждый документ состоит из смеси тем и что каждая тема состоит из набора слов, а это означает, что если мы сможем обнаружить эти скрытые темы, мы сможем раскрыть смысл наших текстов.

Из множества методов тематического моделирования Скрытое распределение Дирихле (LDA) , вероятно, является наиболее часто используемым. Этот относительно новый алгоритм (придуманный менее 20 лет назад) работает как метод обучения без учителя, который обнаруживает различные темы, лежащие в основе набора документов. В методах неконтролируемого обучения , подобных этому, нет выходной переменной для управления процессом обучения, и данные исследуются алгоритмами для поиска закономерностей. Чтобы быть более конкретным, LDA находит группы связанных слов по:

Этот относительно новый алгоритм (придуманный менее 20 лет назад) работает как метод обучения без учителя, который обнаруживает различные темы, лежащие в основе набора документов. В методах неконтролируемого обучения , подобных этому, нет выходной переменной для управления процессом обучения, и данные исследуются алгоритмами для поиска закономерностей. Чтобы быть более конкретным, LDA находит группы связанных слов по:

- Назначение каждого слова случайной теме, где пользователь определяет количество тем, которые он хочет раскрыть. Вы не определяете сами темы (вы определяете только количество тем), и алгоритм сопоставляет все документы с темами таким образом, что слова в каждом документе в основном захватываются этими воображаемыми темами.

- Алгоритм итеративно перебирает каждое слово и переназначает слово теме, принимая во внимание вероятность того, что слово принадлежит теме, и вероятность того, что документ будет сгенерирован темой. Эти вероятности вычисляются многократно, до сходимости алгоритма.

В отличие от других алгоритмов кластеризации, таких как K-средних , которые выполняют жесткую кластеризацию (где темы не пересекаются), LDA присваивает каждому документу смесь тем, что означает, что каждый документ может быть описан одной или несколькими темами (например, Document 1 описывается на 70 % по теме А, на 20 % по теме В и на 10 % по теме С) и отражает более реалистичные результаты.

Тематическое моделирование чрезвычайно полезно для классификации текстов, создания рекомендательных систем (например, чтобы рекомендовать вам книги на основе ваших прошлых чтений) или даже для выявления тенденций в онлайн-публикациях.

В настоящий момент НЛП борется за обнаружение нюансов в значении языка, будь то из-за отсутствия контекста, орфографических ошибок или диалектных различий.

В марте 2016 года Microsoft запустила Tay , чат-бот с искусственным интеллектом (ИИ), выпущенный в Твиттере в качестве эксперимента НЛП. Идея заключалась в том, что чем больше пользователей будет общаться с Таем, тем умнее он станет.

В полученной цепочке символов каждая буква заменяется буквой, следующей за ней в русском алфавите (А — на Б, Б — на В и т. д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.

В полученной цепочке символов каждая буква заменяется буквой, следующей за ней в русском алфавите (А — на Б, Б — на В и т. д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.

Получившаяся таким образом цепочка является результатом работы алгоритма.

Получившаяся таким образом цепочка является результатом работы алгоритма. д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.

д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма. д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.

д., а Я — на А). Получившаяся таким образом цепочка является результатом работы алгоритма.

']

']

В отличие от стемминга, лемматизация пытается выбрать правильную лемму в зависимости от контекста.

В отличие от стемминга, лемматизация пытается выбрать правильную лемму в зависимости от контекста. у', 'собственный', 'такой же', 'так', 'чем', 'тоже', 'очень', 'с', 'т', 'может', 'будет', 'просто', 'дон' , «не», «должен», «должен был», «сейчас», «д», «лл», «м», «о», «ре», «ве», «у», «у». ain', 'арен', "не", 'могл', "не мог", 'делал', "не делал", 'не делает', 'не имел', 'имел' т», «имеет», «не имеет», «убежище», «не имеет», «есть», «не является», «ма», «может», «не может», «должен» , «не должен», «нужен», «не должен», «шань», «не должен», «должен», «не должен», «был», «не был», «были» , «не было», «выиграл», «не будет», «будет», «не будет»]

у', 'собственный', 'такой же', 'так', 'чем', 'тоже', 'очень', 'с', 'т', 'может', 'будет', 'просто', 'дон' , «не», «должен», «должен был», «сейчас», «д», «лл», «м», «о», «ре», «ве», «у», «у». ain', 'арен', "не", 'могл', "не мог", 'делал', "не делал", 'не делает', 'не имел', 'имел' т», «имеет», «не имеет», «убежище», «не имеет», «есть», «не является», «ма», «может», «не может», «должен» , «не должен», «нужен», «не должен», «шань», «не должен», «должен», «не должен», «был», «не был», «были» , «не было», «выиграл», «не будет», «будет», «не будет»]

NLP используется для отслеживания новостей, отчетов, комментариев о возможных слияниях между компаниями, затем все это может быть включено в торговый алгоритм для получения огромной прибыли. Помните: покупайте слухи, продавайте новости.

NLP используется для отслеживания новостей, отчетов, комментариев о возможных слияниях между компаниями, затем все это может быть включено в торговый алгоритм для получения огромной прибыли. Помните: покупайте слухи, продавайте новости.

Leave A Comment